3.1 elastic-spark.md

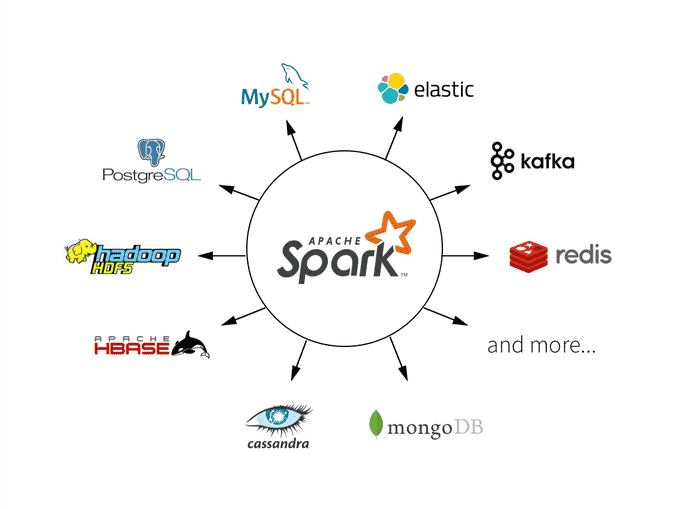

elastic spark

一、原生RDD支持

1.1 基础配置

1.2 读取es数据

1.3 写数据

二、Spark Streaming

三、Spark SQL

四、Spark Structure Streaming

五、Spark on kubernetes Operator

参考:

最后更新于